目录

- 一、为什么需要爬取多页数据并合并到Excel

- 二、技术选型:工具组合决定效率

- 1. 核心工具三件套

- 2. 替代方案对比

- 三、实战案例:爬取招聘网站多页数据

- 1. 环境准备

- 2. 基础爬虫框架

- 3.javascript 多页数据抓取逻辑

- 4. 数据写入Excel(含样式)

- 四、关键技术点解析

- 1. 反爬机制应对策略

- 2. 数据清洗技巧

- 3. Excel样式优化建议

- 五、性能优化方案

- 1. 多线程加速

- 2. 内存管理技巧

- 3. 异常恢复机制

- 六、常见问题Q&A

- 七、进阶方向建议

一、为什么需要爬取多页数据并合并到Excel

在互联网时代,数据就是生产力。当你需要分析电商商品价格趋势、监控新闻舆情动态,或是收集招聘信息做行业研究时,经常会遇到目标数据分散在多个网页的情况。手动复制粘贴不仅效率低下,还容易出错。通过自动化爬虫技术批量抓取多页数据,再整合到结构清晰的Excel文件中,能大幅提升工作效率。

更关键的是,Excel不仅是数据存储工具,更是强大的分析平台。通过设置条件格式、数据透 视表、图表等功能,能让原始数据立即转化为可视化洞察。比如将不同页面的商品价格用颜色深浅区分,或用折线图展示价格波动趋势,这些操作都需要数据先完成合并。

二、技术选型:工具组合决定效率

1. 核心工具三件套

- python:作为脚本语言,其简洁的语法和丰富的库生态是爬虫开发首选

- Requests:处理HTTP请求的轻量级库,比原生urllib更易用

- BeautifulSoup:解析html的利器,能精准定位DOM元素

- OpenPyXL:专门处理Excel文件的库,支持样式设置和公式计算

2. 替代方案对比

| 工具类型 | 适用场景 | 优势 | 局限 |

|---|---|---|---|

| Python脚本 | 复杂网站/定制化需求 | 灵活可控,可处理JavaScript渲染 | 需要编程基础 |

| 八爪鱼采集器 | 非技术人员快速上手 | 可视化操作,支持云采集 | 高级功能需付费 |

| Excel Power Query | 已下载的CSV/Excel数据整合 | 内置工具无需安装 | 无法直接抓取网页数据 |

建议初学者从Python方案入手,虽然需要学习基础语法,但长期来看可扩展性最强。以爬取某电商平台商品信息为例,使用Python能轻松实现自动翻页、异常处理、数据清洗等完整流程。

三、实战案例:爬取招聘网站多页数据

1. 环境准备

安装必要库:

pip install requests beautifulsoup4 openpyxl fake-useragent

2. 基础爬虫框架

import requests

from bs4 import BeautifulSoup

from fake_useragent import UserAgent

def fetch_page(url):

headers = {'User-Agent': UserAgent().random}

try:

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status()

return response.text

except requests.exceptions.RequestException as e:

print(f"请求失败: {e}")

return None

3. 多页数据抓取逻辑

假设目标网站URL格式为https://example.com/jobs?page=1,每页www.devze.com显示20条数据:

def scrape_job_data(max_pages):

base_url = "https://example.com/jobs?page="

all_data = []

for page in range(1, max_pages+1):

html = fetch_page(base_url + str(page))

if not html:

continue

soup = BeautifulSoup(html, 'html.parser')

job_list = soup.find_all('div', class_='job-item') # 根据实际HTML结构调整

for job in job_list:

title = job.find('h2').text.strip()

company = job.find('div', class_='company').text.strip()

salary = job.find('span', class_='salary').text.hGMYLWstrip() if job.find('span', class_='salary') else '面议'

all_data.append([title, company, salary])

return all_data

4. 数据写入Excel(含样式)

from openpyxl import Workbook

from openpyxl.styles import Font, PatternFill, Alignment, Border, Side

def save_to_excel(data, filename):

wb = Workbook()

ws = wb.active

ws.title = "招聘信息"

# 写入表头

headers = ['职位名称', '公司名称', '薪资范围']

ws.append(headers)

# 设置表头样式

header_font = Font(bold=True, color="FFFFFF")

header_fill = PatternFill("solid", fgColor="4F81BD")

header_align = Alignment(horizontal="cente编程客栈r", vertical="center")

for cell in ws[1]:

cell.font = header_font

cell.fill = header_fill

cell.alignment = header_align

# 写入数据

for row in data:

ws.append(row)

# 设置数据行样式

thin_border = Border(left=Side(style='thin'),

right=Side(style='thin'),

top=Side(style='thin'),

bottom=Side(style='thin'))

for row in ws.iter_rows(min_row=2, max_row=ws.max_row, max_col=3):

for cell in row:

cell.border = thin_border

cell.alignment = Alignment(horizontal="center")

# 自动调整列宽

for column in ws.columns:

max_length = 0

column_letter = column[0].column_letter

for cell in column:

try:

if len(str(cell.value)) > max_length:

max_length = len(str(cell.value))

except:

pass

adjusted_width = (max_length + 2) * 1.2

ws.column_dimensions[column_letter].width = adjusted_width

wb.save(filename)

print(f"数据已保存到 {filename}")

# 执行爬取并保存

job_data = scrape_job_data(5) # 爬取5页数据

save_to_excel(job_data, "招聘信息汇总.xlsx")

四、关键技术点解析

1. 反爬机制应对策略

- User-Agent轮换:使用

fake_useragent库模拟不同浏览器访问 - 请求间隔控制:在循环中添加

time.sleep(random.uniform(1,3)) - IP代理池:当遇到IP封禁时,需准备多个代理IP轮流使用

2. 数据清洗技巧

- 去除空白字符:使用

.strip()方法处理文本 - 异常值处理:用三元表达式设置默认值(如薪资字段)

- 日期格式统一:通过

datetime.strptime()标准化时间数据

3. Excel样式优化建议

- 条件格式:用

ConditionalFormatting实现数据可视化 - 数据验证:设置下拉列表限制输入内容

- 冻结窗格:

ws.freeze_panes = 'A2'固定表头 - 公式应用:可直接在单元格写入Excel公式如

=SUM(B2:B100)

五、性能优化方案

1. 多线程加速

from concurrent.futures import ThreadPoolExecutor

def parallel_scrape(url_list):

with ThreadPoolExecutor(max_workers=5) as executor:

results = executor.map(fetch_page, url_list)

return list(results)

2. 内存管理技巧

- 分批写入Excel:每爬取100条数据就写入一次,避免内存溢出

- 使用生成器:将

all_data改为生成器模式,减少中间存储

3. 异常恢复机制

- 记录已爬取页码:将进度保存到文本文件,中断后可续爬

- 失败重试机制:对失败请求自动重试3次

六、常见问题Q&A

Q1:被网站封IP怎么办?

A:立即启用备用代理池,建议使用住宅代理(如站大爷IP代理),配合每请求更换IP策略。更稳妥的方式是降低爬取频率,在请求间添加2-5秒随机延迟。

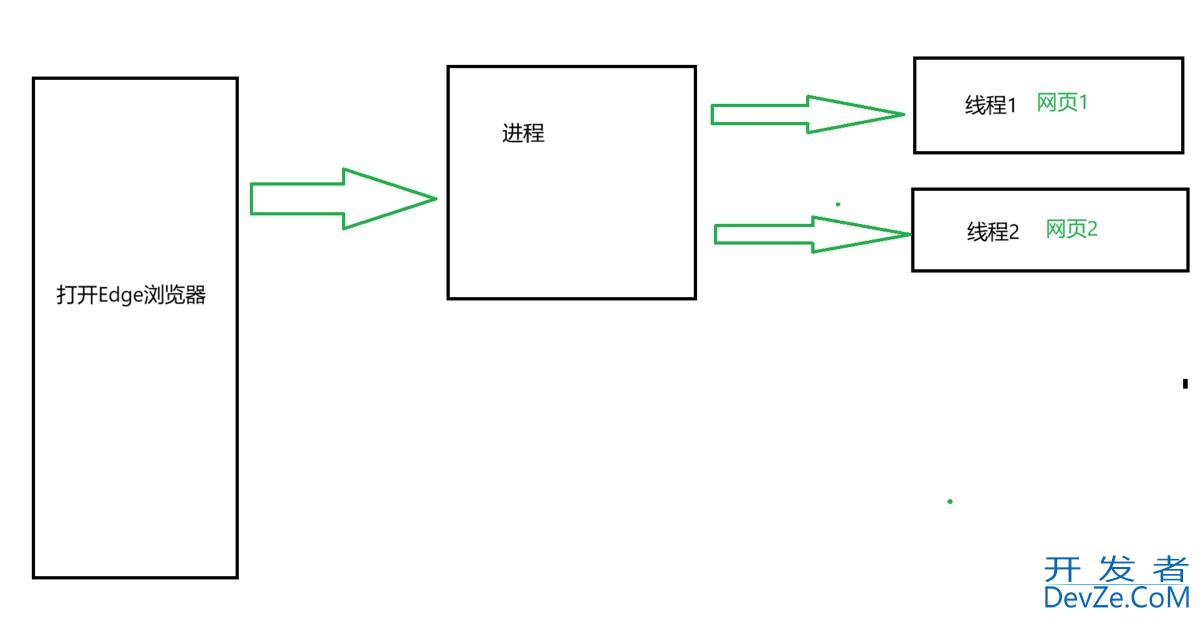

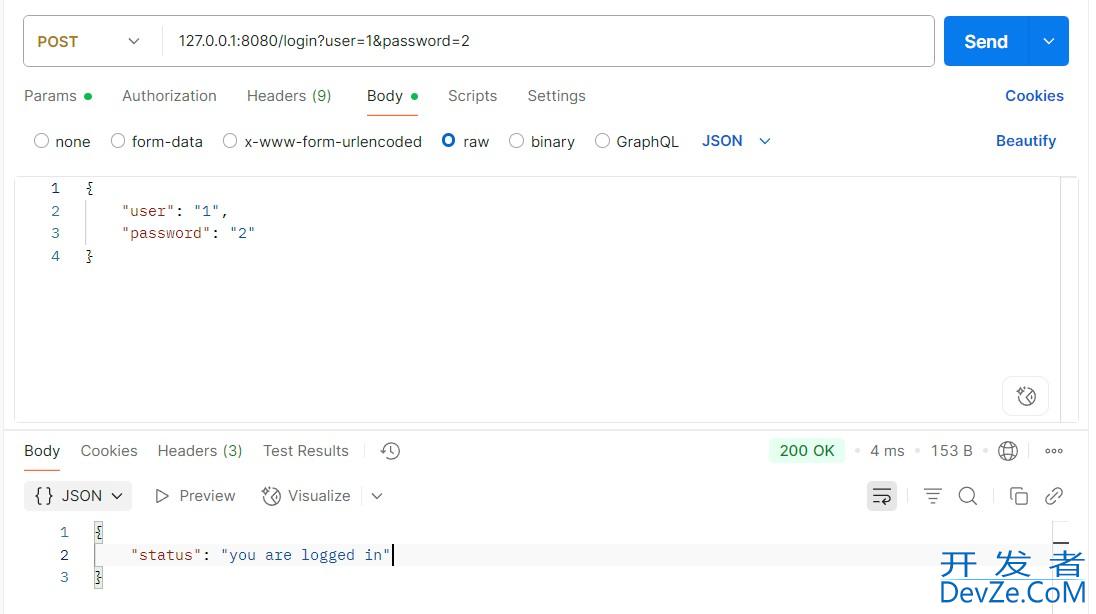

Q2:如何处理javascript渲染的页面?

A:对于动态加载的数据,可使用Selenium或Playwright模拟浏览器行为,或通过分析XHR请求直接获取API接口数据。

Q3:Excel文件过大导致卡顿如何解决?

A:将数据拆分为多个工作表,或使用xlsxwriter库的optimize_for_speed()模式。对于超大数据集,建议改用CSV格式存储,用Excel只处理分析部分。

Q4:如何定时自动执行爬虫?

A:Windows可用任务计划程序,linux可用crontab设置定时任务。更复杂的场景建议使用Airflow等工作流引擎。

Q5:爬取的数据与实际显示不符?

A:检查是否遗漏了隐藏的DOM元素,或网站有反爬机制返回了虚假数据。可通过对比浏览器开发者工具中的Network请求,确认是否抓取了正确的数据接口。

七、进阶方向建议

- 数据可视化:用Pandas+Matplotlib将Excel数据转化为专业图表

- 自动化报告:结合Win32com或Xlwings实现Excel自动排版

- 分布式爬取:用Scrapy-Redis构建集群化爬虫系统

- 机器学习应用:将爬取的数据用于价格预测或情感分析模型训练

掌握这些技术后,你不仅能高效完成数据采集任务,更能构建完整的数据处理流水线。从网页抓取到Excel美化,每个环节都蕴含着优化空间,建议在实际项目中不断迭代改进,形成自己的技术工具箱。

到此这篇关于Python实现http://www.devze.com爬取多页数据并合并为Excel的实用指南的文章就介绍到这了,更多相关Python数据合并为Excel内容请搜索编程客栈(www.devze.com)以前的文章或继续浏览下面的相关文章希望大家以后多多支持编程客栈(www.devze.com)!

加载中,请稍侯......

加载中,请稍侯......

精彩评论