目录

- 一、Ray 核心概念

- 1. Ray 集群

- 2. 任务(Tasks)

- 3. Actor

- 4. 对象存储(Object Store)

- 二、Ray 高级特性

- 1. js资源管理

- 2. 容错与弹性

- 3. 与机器学习库集成

- 三、Ray 应用场景

- 1. 并行计算

- 2. 分布式机器学习

- 3. 实时流处理

- 四、Ray 部署与扩展

- 1. 本地部署

- 2. 云部署

- 3. Kubernetes 部署

- 五、Ray 最佳实践

- 六、总结

Ray 是一个开源的分布式计算框架,专为扩展 python 应用程序而设计,尤其在人工智能和机器学习领域表现出色。它提供了简单的 API,使开发者能够轻松编写并行和分布式代码,而无需关注底层复杂性。以下是关于 Python Ray 扩展的详细指南。

一、Ray 核心概念

1. Ray 集群

Ray 集群由一个头节点(Head Node)和多个工作节点(Worker Nodes)组成。头节点负责协调任务分配和资源管理,而工作节点则执行具体的计算任务。Ray 集群可以部署在本地机器、云平台或 Kubernetes 上。

2. 任务(Tasks)

任务是 Ray 中最基本的执行单元。通过 @ray.remote 装饰器,可以将普通函数转换为远程任务。任务可以在集群中的任何节点上并行执行。

import ray

ray.init() # 初始化 Ray 集群

@ray.remote

def add(x, y):

return x + y

# 提交任务

result_id = add.remote(1, 2)

# 获取任务结果

result = ray.get(result_id)

print(result) # 输出: 3

3. Actor

Actor 是 Ray 中的有状态对象,可以包含状态和方法。与任务不同,Actor 的方法调用会在同一个 Actor 实例上执行,从而维护状态。

@ray.remote

class Counter:

def __init__(self):

self.value = 0

def increment(self):

self.value += 1

return self.value

# 创建 Actor 实例

counter = Counter.remote()

# 调用 Actor 方法

for _ in range(5):

print(ray.get(counter.increment.remote())) # 输出: 1, 2, 3, 4, 5

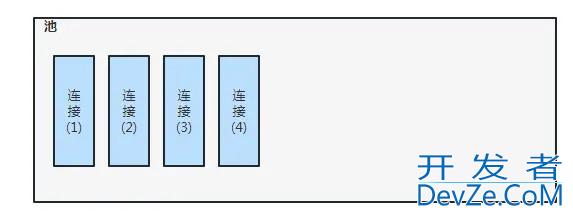

4. 对象存储(Object Store)

Ray 提供了分布式对象存储系统,用于在集群中共享数据。数据可以通过 ray.put() 存储,并通过 ray.get() 检索。

data = [1, 2, 3, 4, 5] data_id = ray.put(data) # 将数据存储到对象存储 retrieved_data = ray.get(data_id) # 从对象存储检索数据 print(retrieved_data) # 输出: [1, 2, 3, 4, 5]

二、Ray 高级特性

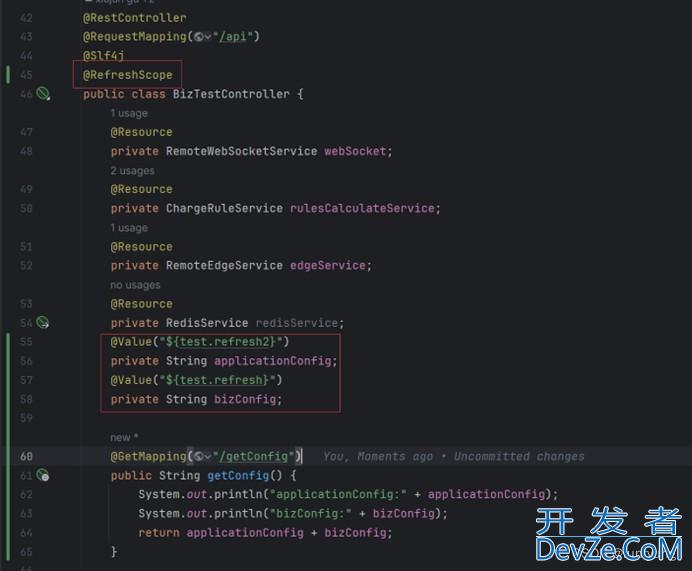

1. 资源管理

Ray 允许为任务和 Actor 指定资源需求(如 CPU、GPU 等)。集群调度器会根据资源请求分配任务。

@ray.remote(num_gpus=1) # 请求 1 个 GPU

def train_model(data):

# 模型训练代码

pass

2. 容错与弹性

Ray 提供了容错机制,当节点故障时,任务可以重新调度到其他节点执行。此外,Ray 支持动态扩展集群,根据负载自动添加或删除节点。

3. 与机器学习库集成

Ray 提供了多个专用库,用于简化机器学习工作流:

- Ray Tune:超参数调优库,支持并行化搜索。

- Ray Train:分布式训练库,支持多种深度学习框架(如 TensorFlow、PyTorch)。

- Ray RLlib:强化学习库,支持分布式训练。

- Ray Serve:模型服务库,支持快速部署和扩展。

三、Ray 应用场景

1. 并行计算

Ray 可以将计算密集型任务拆分为多个子任务,并行执行,从而显著加速计算。

import ray

import time

ray.init()

@ray.remote

def compute_heavy_task(i):

time.sleep(1) # 模拟耗时计算

return i * i

# 提交多个任务

result_ids = [compute_heavy_task.remote(i) for i in range(10)]

# 获取结果

results = ray.get(result_ids)

print(results) # 输出: [0, 1, 4, 9, 16, 25, 36, 49, 64, 81]

2. 分布式机器学习

Ray 可以与 PyTorch 或 TensorFlow 结合,实现分布式模型训练。

import ray

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import DataLoader, TensorDataset

ray.init()

# 定义简单模型

class SimpleModel(nn.Module):

def __init__(self):

super().__init__()

编程 self.linear = nn.Linear(10, 1)

def forward(self, x):

return self.linear(x)

# 模拟数据

X = torch.randn(1000, 10)

y = torch.randn(1000, 1)

dataset = TensorDataset(X, y)

dataloader = DataLoader(dataset, BATch_size=32)

# 分布式训练函数

@ray.remote

def train_epoch(model_weight_id, dataloader_id, epoch):

model_weight = ray.get(model_weight_id)

model = SimpleModel()

model.load_state_dict(model_weight)

criterion = nn.MSELoss()

optimizer = optim.SGD(model.parameters(), lr=0.01)

dataloader = ray.get(dataloader_id)

for batch_X, batch_y in dataloader:

optimizer.zero_grad()

outputs = model(batch_X)

loss = criterion(outputs, batch_y)

loss.backward()

optimizer.step()

# 返回更新后的模型权重

updated_weight = model.state_dict()

return updated_weight

# 初始化模型权重

model = SimpleModel()

initial_weight = model.state_dict()

weight_id = ray.put(initial_weight)

dataloader_id = ray.put(dataloader)

# 提交多个训练任务

for epoch in range(5):

weight_id = train_epoch.remote(weight_id, dataloader_id, epoch)

# 获取最终模型权重

final_weight = ray.get(weighwww.devze.comt_id)

print("Training completed!")

3. 实时流处理

Ray 可以与 Kafka 等流处理系统结合,实现实时数据处理。

import ray

from confluent_kafka import Producer, Consumer

ray.init()

@ray.remote

class KafkaProducerActor:

def __init__(self, bootstrap_servers):

self.producer = Producer({'bootstrap.servers': bootstrap_servers})

def produce(self, topic, message):

self.producerSqtyUYCI.produce(topic, value=message)

self.producer.flush()

@ray.remote

class KafkaConsumerActor:

def __init__(self, bootstrap_servers, group_id, topic):

self.consumer = Consumer({

'bootstrap.servers': bootstrap_servers,

'group.id': group_id,

'auto.offset.reset': 'earliest'

})

self.consumer.subscribe([topic])

def consume(self):

msg = self.consumer.poll(1.0)

if msg is not None and msg.error() is None:

return msg.value().decode('utf-8')

编程客栈 return None

# 创建生产者和消费者 Actor

producer_actor = KafkaProducerActor.remote('localhost:9092')

consumer_actor = KafkaConsumerActor.remote('localhost:9092', 'test-group', 'test-topic')

# 生产消息

ray.get(producer_actor.produce.remote('test-topic', b'Hello, Ray!'))

# 消费消息

message = ray.get(consumer_actor.consume.remote())

print(f"Received message: {message}") # 输出: Received message: Hello, Ray!

四、Ray 部署与扩展

1. 本地部署

在本地机器上运行 Ray 集群非常简单,只需调用 ray.init() 即可。

import ray ray.init() # 初始化本地 Ray 集群

2. 云部署

Ray 支持在 AWS、GCP、Azure 等云平台上部署。可以通过 Ray 的自动伸缩功能,根据负载动态调整集群规模。

3. Kubernetes 部署

Ray 提供了 Kubernetes 操作符(Ray Operator),可以方便地在 Kubernetes 集群上部署和管理 Ray 集群。

五、Ray 最佳实践

合理分配资源:为任务和 Actor 指定适当的资源需求,避免资源争用。

使用 Actor 管理状态:对于需要维护状态的任务,使用 Actor 而不是普通任务。

优化数据传输:尽量减少节点间的数据传输,利用 Ray 的对象存储共享数据。

监控与调试:使用 Ray 的内置工具监控集群状态和任务执行情况。

六、总结

Ray 是一个强大的分布式计算框架,适用于各种需要扩展 Python 应用程序的场景。通过简单的 API,开发者可以轻松实现并行计算、分布式机器学习和实时流处理。无论是本地开发还是云部署,Ray 都提供了灵活的解决方案。掌握 Ray 的核心概念和高级特性,将帮助你更高效地构建分布式应用。

到此这篇关于Python中分布式框架Ray扩展的详细指南的文章就介绍到这了,更多相关Python Ray扩展内容请搜索编程客栈(www.devze.com)以前的文章或继续浏览下面的相关文章希望大家以后多多支持编程客栈(www.devze.com)!

加载中,请稍侯......

加载中,请稍侯......

精彩评论